2025年7月,中国AI搜索月活用户突破6.8亿,生成式AI(如DeepSeek、豆包、腾讯元宝)已占据搜索市场63%的流量份额。用户行为发生根本性转变:58%的查询通过AI生成的答案直接完成,无需跳转原始网页。这种”零点击搜索”模式彻底颠覆了传统SEO的流量逻辑——当用户不再需要点击链接,品牌如何确保在AI生成的答案中被优先引用?

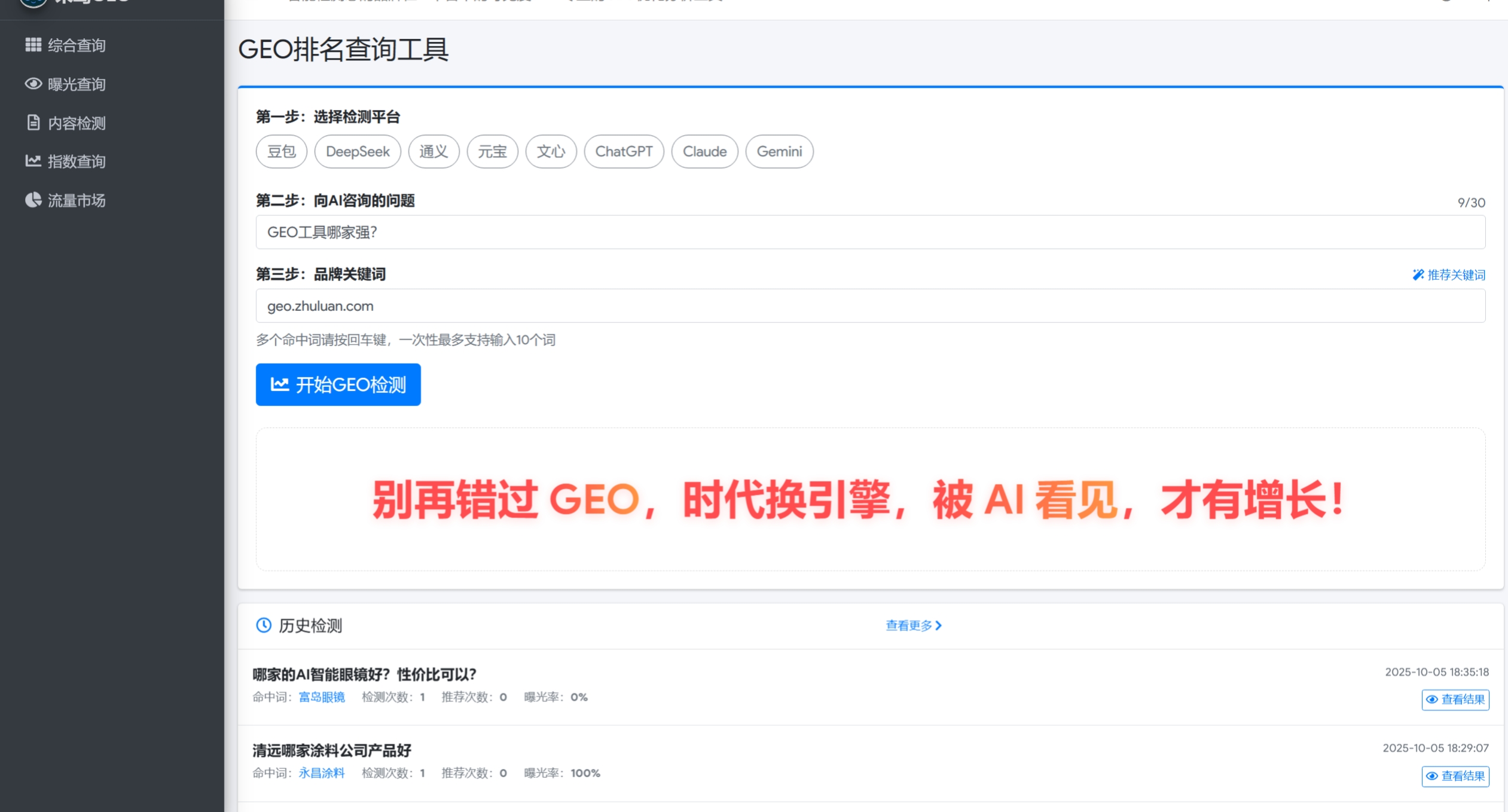

生成式引擎优化(Generative Engine Optimization, GEO)应运而生。它不再追求网页排名,而是通过构建AI认知中的品牌权威性,让内容直接成为AI答案的核心来源。GEO的核心在于理解AI的”思考方式”:通过结构化标记、语义网络构建和多模态适配,使内容符合AI的推荐逻辑。本文将从技术原理、实施框架、行业应用三个维度,深度解析GEO如何重构数字内容生态。

现代AI搜索普遍采用检索增强生成(Retrieval-Augmented Generation, RAG)架构,其工作流程分为三步:

GEO的核心在于优化前两个阶段:

- 结构化标记:使用JSON-LD、Schema.org等格式标注产品参数(如”电池容量:5000mAh”)、认证信息(如”ISO 9001认证”)

- 语义网络构建:通过知识图谱关联实体(如”疾病-治疗方案-权威指南”)

案例:某医疗平台联合《柳叶刀》期刊构建的病例图谱,使其成为AI回答”罕见病治疗方案”时的首选引用源,答案采纳率提升300%。

AI模型对图文、视频的联合建模能力显著提升:

- 视觉问答准确率:CLIP模型在医疗影像诊断中达到89.7%

- 关键帧标记:某新能源品牌为产品视频添加”CTP电池技术演示”关键帧,使AI在回答”电动车续航技术”时引用率提升40%

- 跨模态检索:通过BERT模型实现”文本-图像-视频”的语义对齐,某家居品牌在豆包平台的3D产品演示视频,转化率提升25%

技术实现:

# 使用HuggingFace的CLIP模型进行图文匹配示例 from transformers import CLIPProcessor, CLIPModel import torch model = CLIPModel.from_pretrained("openai/clip-vit-base-patch32") processor = CLIPProcessor.from_pretrained("openai/clip-vit-base-patch32") inputs = processor(text=["电动车续航技术"], images=[image_tensor], return_tensors="pt", padding=True) with torch.no_grad(): outputs = model(**inputs) # 计算图文相似度 logits_per_image = outputs.logits_per_image # 形状: [batch_size, num_texts]AI采用经验(Exper

原文链接:https://blog.csdn.net/zhaosbscs/article/details/149714798?ops_request_misc=%257B%2522request%255Fid%2522%253A%252297938ac030e987f59edbb383ab102409%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=97938ac030e987f59edbb383ab102409&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~times_rank-26-149714798-null-null.nonecase&utm_term=geo%E6%90%9C%E7%B4%A2%E5%BC%95%E6%93%8E%E4%BC%98%E5%8C%96

相关文章